S’il y’a bien une question récurrente de la part des utilisateurs de Google Analytics, ça serait celle de savoir comment arriver à filtrer le trafic de redirection et les spams dans leurs sites web pour ne pas obtenir des données fossés de la part du programme.

Malheureusement, la réponse à cette question n’est pas simple et regroupe un certain nombre de paramètres à connaitre et de nombreuses parties dont;

- Une compréhension profonde de ce que vous avez à faire car ce ne sont pas seulement des robots.

- Une filtration judicieuse avec la configuration d’une vue séparée.

- Le blocage des robots dans Google Analytics

- L’identification manuelle des référenceurs.

- La création d’un filtre "mauvais référent".

- Le blocage minutieux des robots nuisibles du site.

Afin de pouvoir vous aider à vous débarrasser de ce problème préjudiciable, on vous propose ces quelques conseils à suivre:

1. Les robots ne sont pas nuisibles, ils ont juste été conçus de cette manière

Tous les robots ne sont pas nuisibles. Beaucoup, comme Googlebot et Bingbot, nous aident à effectuer nos recherches.

Beaucoup d'autres robots appartiennent à des sociétés comme Screaming Frog, Deep Crawl et SpyFu. Ces robots sont respectueux et non dangereux pour les sites qu'ils explorent et ne sont pas non plus nuisibles pour vos visiteurs.

Les robots que vous voulez bloquer sont ceux qui cherchent à détourner votre trafic, trouver des failles à exploiter dans votre CMS à des fins de piratage, et récupérer votre contenu pour leurs propres intérêts.

Selon l'industrie dans laquelle vous êtes, certaines formes de trafic de robots peuvent être pires que d'autres.

Mais ce ne sont pas seulement les robots dont vous devriez vous inquiéter. Il y a beaucoup de sources de référence qui interfèrent avec votre trafic et faussent vos statistiques par la même occasion.

2. Filtrer le trafic analytique avec sagesse

Lorsque vous débutez ce processus délicat, vous devez être pleinement conscient de ce qui est retiré de votre ensemble de données.

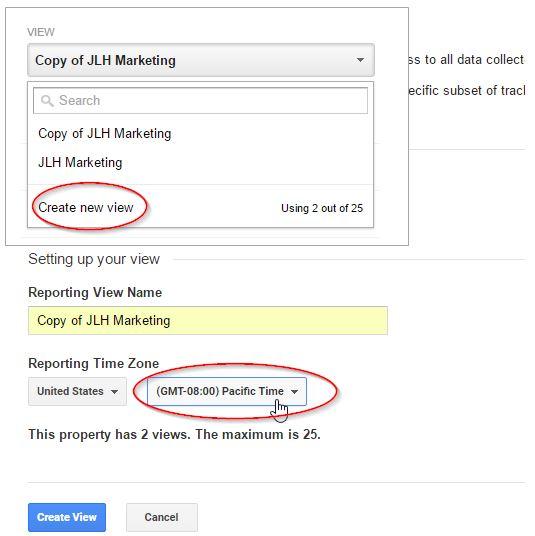

Pour comprendre cela, vous devez effectuer une comparaison en créant une vue distincte dans Google Analytics et lui donner un nom identifiable tel que "Filtrage du trafic de robot".

Pour faire cela :

- Cliquez sur "Admin".

- Puis dans la colonne de droite sous "Vue", cliquez sur le menu déroulant.

- Sélectionnez "Créer une nouvelle vue".

- Sur l'écran suivant, assurez-vous de définir votre fuseau horaire approprié; Google utilise par défaut l’heure du pacifique. Si vous oubliez cette étape, vous ne pourriez pas faire de comparaison dans votre nouvelle vue.

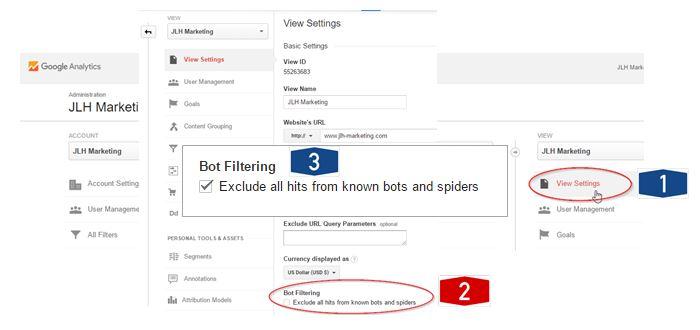

3. Bloquer les robots dans Google Analytics

Google vous donne la possibilité de bloquer les robots connus par son système. Cela vous permet d'éliminer 75 à 80% du travail que vous auriez eu à faire manuellement.

De plus, le système est régulièrement mis à jour lorsque Google trouve de nouveaux robots.

Pour votre nouvelle vue uniquement, sélectionnez l'option "Afficher les paramètres" et cochez la case "Exclure tous les hits des robots et araignées connus" comme indiqué ci-dessous :

Cela vous donnera une idée précise sur ce qui arrivera à votre trafic une fois que vous activez le filtrage des robots.

Vous pouvez ainsi vous assurer qu'aucune de vos sources de trafic importantes ne figure dans la liste connue des robots de Google.

Pour ajouter une annotation, cliquez simplement sur la petite flèche sous n'importe quel graphique d'analyse dans Google Analytics et suivez les instructions comme l’indique l’image ci-dessous ;

4. Ajouter manuellement des redirections de site indésirable

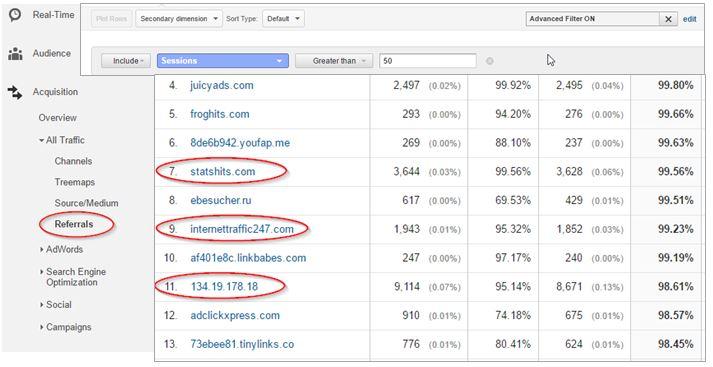

Quel que soit le niveau de qualité du système de filtrage des robots de Google, il y aura inévitablement d'autres référents qui envoient des volumes élevés de trafic à faible qualité sur votre site.

Pour les repérer, ouvrez le rapport du référent dans Google Analytics :

Triez les données en fonction du taux de rebond d’une manière décroissante, de sorte que le taux de rebond à 100% atteigne le haut du classement.

Enfin, filtrez les données en utilisant le filtre avancé pour afficher uniquement un nombre de sessions supérieur à un certain seuil. Cela varie en fonction de votre volume de traffic.

Vous pouvez maintenant faire défiler la liste et rechercher les sites que vous souhaitez ajouter à votre liste d'exclusion de sites référents.

Bien évidement, vous devez confirmer la liste auprès d'autres parties prenantes de votre entreprise afin de vous assurer que vous n’allez pas bloquer des sites que ces derniers veulent voir.

C'est une autre raison pour laquelle vous devriez d'abord tester ceci dans une vue séparée.

Une fois que vous avez votre liste de sites à filtrer, assurez vous de n’utiliser que les noms de domaine principaux.

Par exemple, dans notre exemple ci-dessus, af401e8c.linkbabes.com est probablement lié à linkbabes.com. Il est donc préférable de n’ajouter que linkbabes.com à votre liste d'exclusion.

Il est à noter que vous pourriez trouver des sites Web risqués dans ces listes. Je vous recommande vivement de ne pas visiter l'un d'entre eux pour "les vérifier" ou vous aurez peu être à gérer des logiciels malveillants ou des logiciels espions indésirables.

Une fois que votre liste est entièrement vérifiée et que vous êtes sûr que vous ne bloquerez pas le trafic important que quelqu'un d'autre dans votre organisation veut voir, créez un filtre référent personnalisé.

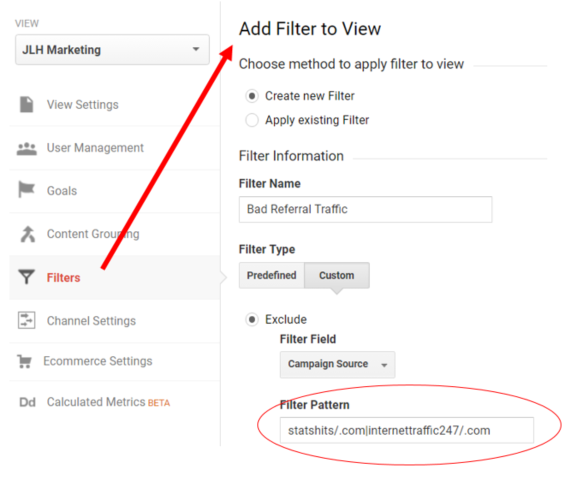

5. Créer un filtre référent

Pour configurer le filtre:

- Sélectionnez "Admin".

- Sous "Vue", sélectionnez "Filtre".

- Cliquez sur "Ajouter un filtre" et donnez un nom au filtre.

- Cliquez sur "Personnaliser" et "Exclure".

- Sélectionnez "Source de la campagne" comme "Champ de filtrage" et entrez les domaines que vous souhaitez exclure dans la zone.

Faites-le d'abord dans un bloc-notes ou dans un document Word, puis collez-le pour ne pas commettre d’erreurs ;

Assurez-vous de tester votre filtre et de le mettre à jour fréquemment lorsque vous trouvez de nouveaux domaines à exclure.

6. Bloquer les robots nuisibles de votre site Web

Ceci n'est pas pour les débutants car cela implique d'utiliser .htaccess ou web config dans IIS qui est l'épine dorsale de tout votre site.

Un mauvais caractère peut entraîner la perte de tout votre site. Donc, vous devez faire une copie de sauvegarde, assurez-vous que vous avez accès directement à votre serveur (l’accès via WordPress ne compte pas) et travailler doucement et soigneusement.

Le fichier .htaccess est un outil puissant à votre disposition car vous pouvez totalement empêcher un trafic de robot avec un volume élevé ou nul d'accéder à votre serveur.

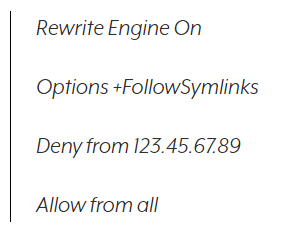

Le code à utiliser est :

Vous devrez intégrer ce code dans votre fichier .htaccess existant, donc il ne faut pas le copier/ coller. Rappelez-vous, un mauvais caractère peut entrainer la perte de votre site.

Ce moyen est efficace pour bloquer le trafic de robots qui placent une charge élevée sur votre serveur, mais il ne devrait pas être utilisé pour n'importe qui.

Donc, ne l'utilisez pas par exemple pour bloquer les anciens employés ! Et n'oubliez pas que les adresses IP changent.

Si vous rencontrez un problème de sécurité sérieux, contactez votre hébergeur ou votre administrateur système pour obtenir de l'aide.

Laissez vos commentaires